El director científico del CERN presenta los últimos resultados del LHC, que “han superado todas las expectativas”

En el Gran Colisionador de Hadrones (LHC) del CERN, donde hace cuatro años se descubrió el famoso bosón de Higgs, acaban de batirse varios récords. La cosecha de datos obtenida en la temporada de operaciones 2016, que concluyó hace solo unas semanas, es muy superior a la esperada, y los físicos están pletóricos. De ello habló el 16 de noviembre en la Fundación BBVA, en Madrid, el director de Investigación y Computación del CERN, Eckhard Elsen, responsable de todo el programa científico y computacional de este organismo. Elsen se recrea ya en los primeros resultados de este año, que llegarán en breve: “Hay mucha excitación; se preparan las conferencias de invierno, en las que esperamos una importante puesta al día. Habrá nuevos resultados y se pondrá límites más estrictos a las teorías que van más allá del Modelo Estándar”, afirma.

14 noviembre, 2016

Elsen ha cerrado esta edición del ciclo sobre física de partículas de la Fundación BBVA y el CERN. Su conferencia, titulada ‘Observaciones en mitad del Run 2’, se ha centrado en el análisis de los datos recogidos en 2015 y 2016. Son resultados preliminares, puesto que la actual fase de operaciones del LHC, apodada ‘Run 2’ e iniciada en 2015, se prolonga hasta 2018. Durante esta segunda etapa de funcionamiento, el LHC está operando a una energía nunca antes alcanzada, 13 TeV, lo que significa que “estamos en un terreno inexplorado”, ha dicho Elsen, “y eso es siempre emocionante para un científico, nos obliga a estar abiertos a todas las posibilidades”.

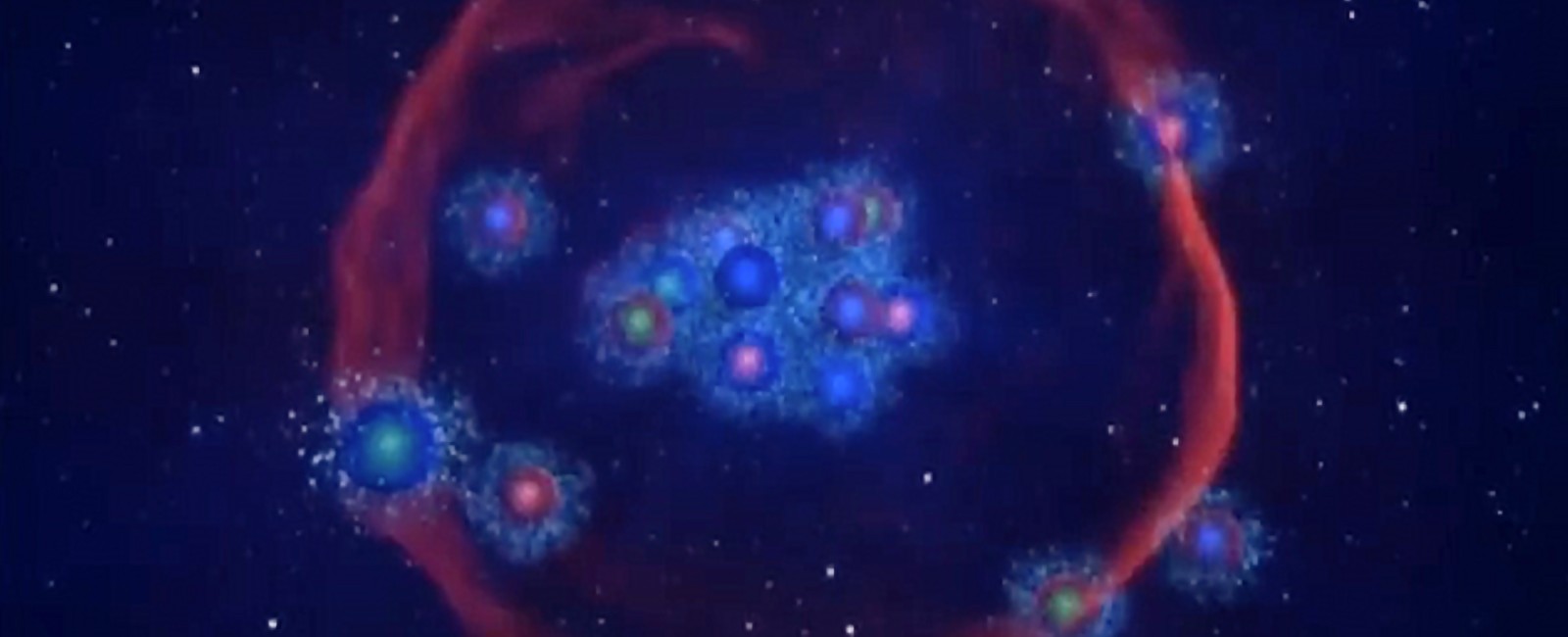

En el LHC los protones viajan a velocidades próximas a las de la luz, y el objetivo es que choquen unos contra otros, cuantas más veces mejor. En estas colisiones su energía se transforma en masa, lo que significa que se generan partículas nuevas, que es lo que los físicos quieren estudiar. El bosón de Higgs fue una de esas nuevas partículas, creada durante el primer periodo de operaciones del LHC, el Run 1. Que el LHC opere a más energía abre vías a la obtención de nuevas partículas más masivas, quizá las integrantes de la misteriosa materia oscura -la forma de materia más abundante en el universo, y sin embargo del todo desconocida aún-.

Pero esta etapa de operaciones del LHC puede deparar más sorpresas, además de la materia oscura. Podrían aparecer otros bosones de Higgs, más masivos que el ya detectado, o tal vez agujeros negros microscópicos, que implicarían nada menos que la existencia de dimensiones adicionales. Elsen no aclara cuál sería su resultado preferido, la respuesta que más ansiosamente espera del LHC: “Es cuestión de gusto personal”.

“Sabemos que el Modelo Estándar no basta para explicar el mundo que nos rodea”, prosigue.“La cuestión de la materia oscura no es más que una pregunta para la que debe hallarse una respuesta, y en la que unen fuerzas varias áreas de la ciencia”

Cuando concluya el Run 2, en 2018, “los resultados iniciales estarán disponibles de forma inmediata, y los resultados de precisión llegarán durante el el ‘Long Shutdown 2 (LS2)‘”, explica Elsen. El LS2 es el segundo gran parón, un periodo en que el LHC y sus detectores se someten a mejoras que permitirán aumentar aún más la energía de operaciones -ya hubo un primer LS1 tras el Run 1-.

Productividad récord

Por lo pronto, la noticia es que este año se han batido récords en lo que respecta a la generación de datos en el LHC. “El volumen de datos en 2016 ha superado todas las expectativas. La tasa de obtención de datos en 2016 superó los 10 petabytes por mes en los momentos pico”, dice Elsen.

Hay dos cifras que alegran especialmente a los físicos. Una hace referencia a las colisiones entre protones -el fenómeno en que se generan los datos-, que se mide en una unidad llamada femtobarn inverso: en 2016 el LHC alcanzó los 40 femtobarn inversos, cuando el objetivo estaba en 25. En 2012 se llegó a 23, y se consideró un gran éxito. Barn significa literalmente granero -el término nació en un congreso en el medio-oeste estadounidense, lleno de granjes, en la época de la investigación en la bomba atómica-; es una unidad de superficie que mide la sección del haz de los protones que deben chocar.

El otro gran número relacionado con la productividad del LHC se refiere al tiempo en que el acelerador ha estado realmente lanzando haces de protones, y que en 2016 ha llegado a ser un 60% del tiempo operacional. El objetivo estaba en 50%, y se consideraba muy optimista para un gran acelerador.

En un reciente post en el blog del CERN Frédérick Bordry, director de Aceleradores y Tecnologías del CERN -y primer conferenciante de esta edición del ciclo de conferencias en la Fundación BBVA- afirmaba: “No puedo resaltar lo bastante la importancia de este dato, porque el número total de colisiones determina la capacidad de los experimentos para llevar a cabo la investigación”.

De la ‘malla’ a la ‘nube’ de computación

Como director de Computación del CERN, Elsen es también responsable de que el análisis de la ingente cantidad de datos generados en el LHC se lleve a cabo de la manera más eficiente posible. El CERN es pionero en esta área, puesto que fue su necesidad de buscar soluciones tecnológicas lo que llevó a la invención de la Web -que hoy usamos todos- y, más tarde, de Grid, la red de recursos de computación que hoy en día hace posible que los datos del LHC sean procesados por computadoras en centros de todo el mundo.

Elsen defiende la necesidad de ir ahora un paso más allá creando una Nube -Cloud- científica. “Es la evolución natural de Grid”. La nube científica permitiría no solo analizar los datos de forma distribuida y eficiente, sino además almacenar estos datos durante largos periodos de tiempo.

Elsen reconoce que este es un aspecto en que el CERN está tecnológicamente por detrás: “Los actuales centros de computación comerciales son más rentables -para los proveedores- que nuestos centros Grid”, dice. “Ahí es donde tenemos que mejorar”.

En una entrada en el blog del CERN Elsen afirmaba: “Mientras CERN construía la WLCG (Worldwide LHC Computing Grid), los Googles y Amazons del mundo construían grandes almacenes de datos para albergar Clouds comerciales. Aunque podríamos recurrir a ellos para satisfacer nuestras necesidades de computación, es dudoso que estas compañías pudieran garantizar la preservación de estos datos durante décadas. Por eso necesitamos una Cloud científica”.